Las redes sociales no son meros canales de comunicación: son sistemas tecnopolíticos diseñados para maximizar el engagement y moldear la percepción pública sin que la mayoría de usuarios lo advierta. Detrás de su aparente neutralidad operan sofisticados algoritmos que priorizan emociones intensas, discursos polarizantes y narrativas alineadas con patrones preestablecidos. Esto no es casualidad, sino el resultado de modelos de optimización que tienen consecuencias sociales y políticas profundas.

Diseño algorítmico: engagement, polarización y filtrar lo neutro

La arquitectura de plataformas como Facebook o X está construida para posicionar el contenido que genera las mayores respuestas: likes, reacciones, comentarios, compartidos. Un estudio de Smitha Milli et al. (2023) demostró que el algoritmo de Twitter amplifica contenido político fuertemente emocional y hostil hacia ‘otros’, a pesar de que los usuarios mismos no lo prefieran. Es decir: no se trata de amplificar lo correcto, sino lo emocionalmente rentable, incluso cuando distorsiona el discurso público.

En YouTube, una revisión de Brookings reveló que su sistema de recomendación genera cámaras de eco suaves: los usuarios no descienden en “cuevas de radicalismo”, pero sí se mantienen en zonas ideológicas estrechas. La personalización crea entornos cerrados, aunque no necesariamente extremos, lo que complica el diálogo entre grupos.

Desde un punto de vista técnico, esto se modeliza combinando redes sociales (quién sigue a quién) con algoritmos de recomendación. Un estudio reciente sobre burbujas filtrantes en Cataluña usó un modelo basado en agentes conectados por vínculos online y offline, concluyendo que la polarización se intensifica cuando algoritmos refuerzan conexiones idénticas (homofilia). En Francia, Reino Unido o EE.UU., auditorías de X (Twitter) basadas en 120 cuentas de prueba (‘sock‑puppets’) mostraron que los usuarios del espectro conservador reciben amplificación exponencial de voces afines, mientras que los liberales experimentan un sesgo menor.

Sesgo político sistémico: X/Twitter y amplificación selectiva

Diversos estudios confirman que el algoritmo de X amplifica sistemáticamente más contenido conservador que liberal. Un estudio interno de Twitter admitió que el algoritmo favorecía mensajes de políticos de derechas en seis de siete países analizados. Esta amplificación fue corroborada por Huszár et al. (2021) a través de un experimento masivo: los mensajes de derechas ganaban ~50 % más visibilidad que los de izquierdas .

La adquisición de Twitter por Elon Musk en 2024 intensificó estos sesgos. Investigaciones de Queensland University of Technology detectaron un aumento del 138 % en la visibilidad de Musk tras anunciar su apoyo electoral a Trump, y otros perfiles conservadores gozaron de incrementos notables. El sesgo dejó de ser un “efecto secundario” accidental: se convirtió en una característica estratégica de la plataforma.

Burbujas filtrantes y claridad mental: el impacto estructural

El concepto de filter bubble, formulado por Eli Pariser en 2011, captura cómo los algoritmos invisibles crean universos de información personalizados. En un experimento con DuckDuckGo y Google, la personalización incluso en modo incógnito generó resultados significativamente distintos para la misma búsqueda . Esto demuestra que la neutralidad es un mito: incluso sin interacción, los sistemas ya filtran la realidad.

La interacción humana agrava el sesgo. En Facebook, el 60 % de los usuarios no siguen políticos, pero interactúan dentro de audiencias ideológicas estrechas. Además, un estudio con bots neutrales encontró que las recomendaciones tienden a conducirse por las preferencias iniciales del usuario, no por el contenido objetivo .

En TikTok, se ha descubierto que el algoritmo puede inducir sesgos basados en la apariencia –recomendando cuentas cuya edad, raza o características físicas coinciden con las del usuario– pese a la negación oficial.

Técnica de amplificación: bots, energía emocional y desigualdades

El impacto algorítmico no termina en el feed. Los bots políticos funcionan como amplificadores funcionalmente integrados. Menczer y su equipo han demostrado que los bots conservadores no solo están más presentes, sino que interactúan con mayor eficacia que los liberales, influyendo en la discusión pública. Los bots trabajan en sincronía con los algoritmos, maximizando su visibilidad.

Junto a esto, los análisis de engagement ranking muestran que el 70 % del contenido polarizante genera más tráfico, incluso cuando los usuarios dicen que prefieren algo diferente .

Otras plataformas: Google, búsqueda y refuerzo ideológico

Google no escapa a este fenómeno. Estudios detectaron que el motor ajusta los resultados según usuario, incluso en modo incógnito. El 2013, se demostró que a quienes buscaban “vacunas” les presentaban información beneficiosa según su perfil . La búsqueda personalizada hace que dos personas vean páginas opuestas al mismo término, sin saber que están dentro de burbujas diferentes.

Transparency versus opacidad: auditorías y regulaciones

Europa ha reaccionado: la Digital Services Act obliga a plataformas como X, Meta y YouTube a documentar sus algoritmos, auditar descargas falsas y nombrar “trusted flaggers” . Pero estas regulaciones priorizan fuentes institucionales —generalmente aliadas con la agenda dominante— mientras no desactivan la lógica de monetización algorítmica.

La regulación propone evaluar “riesgos sistémicos”, pero depende de la misma lógica que generó el problema: engagement, customización y priorización emocional, no pluralidad informativa.

Hacia una resistencia tecnológica: opciones y propuestas

Existen alternativas técnicas basadas en transparencia algorítmica:

-

Feeds cronológicos: algunos desarrolladores y usuarios prefieren orden cronológico en lugar de priorización algorítmica.

-

Auditorías independientes: proyectos como AlgorithmWatch, Mozilla MITI, o universidades como QUT publican informes que contrarrestan narrativas cerradas.

-

Herramientas de descubrimiento: extensiones para cruzar feeds, exponer contenido recomendado a perfiles diferentes, o desactivar filtros.

-

Regulación participativa: auditar algoritmos con la participación de usuarios, ONGs y comunidad técnica, no solo con servidores municipales o estatales.

Conclusión

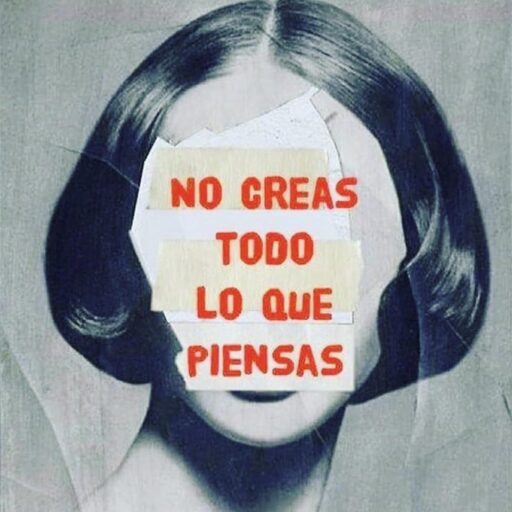

Los algoritmos no son neutros. Son máquinas de priorizar atención, amplificar conflicto y enjaular el debate. Operan en la sombra, invisibles para el ciudadano, pero con efectos profundos en la percepción social, la polarización política y la gobernanza de la información.

Los datos técnicos no sirven para alarmar: sirven para evidenciar una estructura: la plataforma no es un espacio de intercambio libre, sino un ecosistema gestionado por criterios de monetización y control. No basta con regular la exposición: debemos reimaginar el entorno digital como un espacio de diálogo informado, no de captura emocional. Y eso significa recuperar la capacidad de elegir, cuestionar y explorar algo más allá del aneurisma emocional que hoy nos dictan los algoritmos.

La pregunta final que queda es si estamos dispuestos a aceptar feeds preconfigurados o si apostaremos por espacios donde pensar libremente.